zeus_config in Nutanix log bundle

この記事は、Nutanix Advent Calendar 2017 の 14日目です。

#初参加!

以前にログバンドルを作成する方法は記載しましたが、

ログバンドルは、

NCC-logs-<日付>-xxxx.xxxx.tar といったファイルが作成されます。

今回は、http://demo.nutanix.com の AHV 環境から採取したログを

解説いたします。

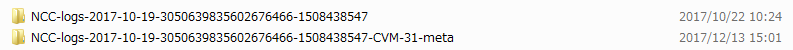

まず、上記 tar ファイルを展開すると 以下の ファイルが出来上がります。

今回は、

NCC-logs-2017-10-19-3050639835602676466-1508438547

NCC-logs-2017-10-19-3050639835602676466-1508438547-CVM-31-meta

の圧縮されたファイルが存在しました。

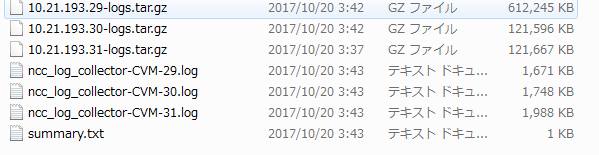

次に、NCC-logs-2017-10-19-3050639835602676466-1508438547 側を展開します。

先頭に IPアドレスがある gz ファイルは 各CVM の IP アドレスです。

次に、このファイルを展開します。

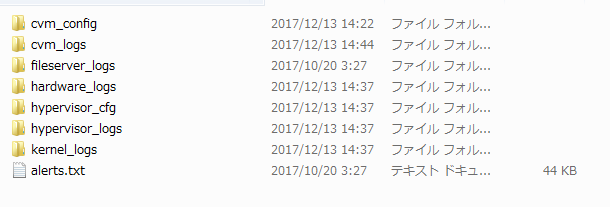

各CVM の gz ファイルには 以下のようにフォルダが分かれています。

それぞれの解説ですが、

・ cvm_config => CVM の設定

・ cvm_logs => CVM 上の各プロセスのログ

・ fileserver_logs => FileServer用 ログ(AFS未使用なら不要)

・ hardware_logs => H/W 情報格納

・ hypervisor_cfg => HyperVisor の 構成情報が格納 ( ESXiならログなし )

・ hypervisor_logs => HyperVisor の ログ情報が格納 ( ESXiならログなし )

・ kernel_logs => dmesg,wtmp が格納

・ alerts.txt => アラート情報

となります。

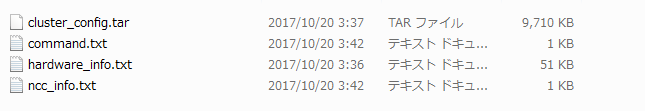

その次に、

NCC-logs-2017-10-19-3050639835602676466-1508438547-CVM-31-meta

を展開します。

それぞれの解説ですが、

・ cluster_config.tar => クラスタの構成情報

・ command.txt => ファイル作成時に使用したコマンド

・ hardware_info.txt => ハードウェア情報

・ ncc_info.txt => NCC の実行結果

となります。

今までの説明を簡易図にすると以下になります。

では、次に個別の説明です。

細かな説明は長くなるので、今回は下記ファイル説明を行います。

○ cluster_config\cluster_config 配下

=> zeus_config.txt

以下のように クラスタの設定ファイルが格納されています。

****Log Collector Start time = 2017/10/19-07:35:41 PDT End time = 2017/10/19-11:35:41 PDT ****

zeus_config:

logical_timestamp: 442109

internal_subnet: "192.168.5.0/255.255.255.128"

external_subnet: "10.21.193.0/255.255.255.0"

storage_tier_list {

storage_tier_name: "SSD-PCIe"

random_io_priority: 9

sequential_io_priority: 9

storage_type: kPcieSSD

}

storage_tier_list {

storage_tier_name: "SSD-SATA"

random_io_priority: 8

sequential_io_priority: 8

storage_type: kSataSSD

}

storage_tier_list {

storage_tier_name: "DAS-SATA"

random_io_priority: 7

sequential_io_priority: 7

storage_type: kHDD

}

========= 略 ===============

そもそも、 zeus とは何でしょぅか?

Nutanix バイブルには 以下のように記載されています。

----

Zookeeper

主な役割: クラスタ構成マネージャー

説明: Apache ZookeeperをベースにしたZookeeperは、ホスト、IP、

状態など全てのクラスタ構成をストアします。本サービスは、

クラスタ内の3つのノードで稼動し、その内の1つがリーダーとして選出されます。

リーダーが全てのリクエストを受信し残りのサービスに転送します。

リーダーからのレスポンスが無い場合、新しいリーダーが自動的に選択されます。

Zookeeperは、Zeusと呼ばれるインターフェースを介してアクセスされます。

----

上記の通り、クラスタの構成情報は zookeeper -> zeus に 情報が

保存されていることになります。

以下、個別説明しましょう。

# でコメントしてます。

---

zeus_config:

logical_timestamp: 442109

internal_subnet: "192.168.5.0/255.255.255.128" # Internal IP

external_subnet: "10.21.193.0/255.255.255.0" # External IP

storage_tier_list {

storage_tier_name: "SSD-PCIe"

random_io_priority: 9

sequential_io_priority: 9

storage_type: kPcieSSD

}

storage_tier_list {

storage_tier_name: "SSD-SATA"

random_io_priority: 8

sequential_io_priority: 8

storage_type: kSataSSD

}

storage_tier_list {

storage_tier_name: "DAS-SATA"

random_io_priority: 7

sequential_io_priority: 7

storage_type: kHDD

}

disk_list { # 各ノード上の Disk の情報が格納 = node x disk 数

disk_id: 62

service_vm_id: 5

mount_path: "/home/nutanix/data/stargate-storage/disks/BTHC5456061U480MGN"

disk_size: 180351879372

statfs_disk_size: 326801059840

storage_tier: "SSD-SATA"

data_dir_sublevels: 2

data_dir_sublevel_dirs: 20

disk_location: 1 # ロケーション

contains_metadata: true

oplog_disk_size: 88376641536

ccache_disk_size: 21474836480

disk_serial_id: "BTHC5456061U480MGN" # シリアルナンバー

disk_uuid: "a8d9172c-5d09-41fa-990f-e67ef045d500" # disk の uuid

node_uuid: "beb4123f-afc9-408e-a789-d0f4e56526b5"

metadata_disk_reservation_bytes: 32212254720

26: "7cc1f58a-a06c-4e43-a5fa-8c8bfaebd0b5"

}

disk_list {

disk_id: 65

service_vm_id: 4

mount_path: "/home/nutanix/data/stargate-storage/disks/Z1X6HNDL"

disk_size: 1787128762572

statfs_disk_size: 1948852449280

storage_tier: "DAS-SATA"

data_dir_sublevels: 2

data_dir_sublevel_dirs: 20

disk_location: 3

disk_serial_id: "Z1X6HNDL"

disk_uuid: "8ce40c4d-3e9a-48e8-a1f4-cb0ff528aac4"

curator_disk_reservation_bytes: 64424509440

is_curator_primary: true

node_uuid: "a3775252-5d6c-4cd2-bd82-024db4004830"

26: "333d8978-7d64-4412-9c7d-1a01ea36ad27"

}

<略>

}

node_list { # 各 node の 情報が格納 => node 数(今回なら3)

service_vm_id: 4

service_vm_external_ip: "10.21.193.29"

node_status: kNormal

hypervisor_key: "10.21.193.25"

management_server_name: "10.21.193.25" # HyperVisor IP

cassandra_token_id: "FV0000006TbNVqegqHHXGSFBY5QtRVda7obAzNfXbhm7Hv6ajSe2PRJiZFPC"

hypervisor {

address_list: "10.21.193.25" # Hypervisor IP

}

ipmi {

address_list: "10.21.193.33" # IPMI の IP

}

zookeeper_myid: 1

uuid: "a3775252-5d6c-4cd2-bd82-024db4004830"

rackable_unit_id: 34

node_position: 1 # node の ポジション

maintenance_mode: false

reason_for_maintenance_mode_list: "Firmware upgrade"

reason_for_maintenance_mode_list: "Hypervisor upgrade"

cassandra_status: kNormalMode

software_version: "el6-release-euphrates-5.1.2-stable-e429c7210f0786ed677edec3eef7e52f4d83881a"

node_serial: "ZM15CS043320"

hardware_config: "/appliance/physical/hardware_configs/f21afbc8fb93e31494ca2e65f2521396"

management_server_id: 64

cassandra_status_history {

cassandra_status: kMetadataRepairRequired

state_change_source: kDetachDueToFrequentRestarts

svm_id_source_of_status_change: 4

cassandra_status_change_timestamp: 1497539042662128

}

cassandra_status_history {

cassandra_status: kMetadataRepairDone

state_change_source: kDynamicRingChanger

svm_id_source_of_status_change: 5

cassandra_status_change_timestamp: 1497542096381603

}

cassandra_status_history {

cassandra_status: kNormalMode

state_change_source: kCassandraMonitor

svm_id_source_of_status_change: 4

cassandra_status_change_timestamp: 1497542099300276

cassandra_token_id: "FV0000006TbNVqegqHHXGSFBY5QtRVda7obAzNfXbhm7Hv6ajSe2PRJiZFPC"

}

acropolis_status {

node_state: kAcropolisNormal

logical_timestamp: 27

}

last_known_metadata_disk_id: 67

cassandra_compaction_pending: false

cluster_uuid: "00052fdc-bb27-00ad-2a56-0cc47ac0eaf2"

rackable_unit_uuid: "84a2fac6-b6d6-4733-b9a5-a6786ab9ce4d"

management_server_uuid: "5e963224-cbc6-475b-8ba4-b12a28ed9869"

cassandra_schema_timestamp: 15

controller_vm_backplane_ip: "10.21.193.29"

cvm_resource_state {

memory_mb: 32175

}

39: "333d8978-7d64-4412-9c7d-1a01ea36ad27"

}

<略>

}

storage_pool_list { # ストレージプールの情報です。

storage_pool_name: "sp-demo"

storage_pool_id: 8

disk_id: 61213623

disk_id: 65

disk_id: 67

disk_id: 18247953

disk_id: 309833743

disk_id: 42237310

disk_id: 61213624

disk_id: 62

disk_id: 61213625

ilm_down_migrate_pct_threshold: 75

total_implicit_reserved_capacity: 7670811590656

storage_pool_uuid: "d22c1983-5928-459c-8a55-3b94b07b46a2"

disk_uuid: "a3cf2bcd-d4fb-408a-91ce-32383a194f98"

disk_uuid: "56df377e-8c6a-4a82-a0d6-4305dc890a10"

disk_uuid: "3ee76099-459f-4f12-b417-2addd3b37963"

disk_uuid: "62d3eccb-24c6-47c1-bb3e-b093932f9fdf"

disk_uuid: "a8d9172c-5d09-41fa-990f-e67ef045d500"

disk_uuid: "4305af14-fc33-477e-af06-872e78c6fca6"

disk_uuid: "5cf9dc39-653a-4664-ad13-e25ac2f05a34"

disk_uuid: "05cb2217-e8cb-4d59-9107-dd6cf22257d8"

disk_uuid: "8ce40c4d-3e9a-48e8-a1f4-cb0ff528aac4"

}

container_list { # コンテナ情報。

container_name: "NTNX-AHV-PROD"

container_id: 121883

storage_pool_id: 8

params {

replication_factor: 2 # コンテナのRF値

compression_type: kLow

random_io_tier_preference: "SSD-PCIe"

random_io_tier_preference: "SSD-SATA"

random_io_tier_preference: "DAS-SATA"

sequential_io_tier_preference: "SSD-PCIe"

sequential_io_tier_preference: "SSD-SATA"

sequential_io_tier_preference: "DAS-SATA"

total_explicit_reserved_capacity: 0

max_capacity: 11338003414323

ilm_down_migrate_time_secs: 1800

ilm_down_migrate_time_secs: 1800

ilm_down_migrate_time_secs: 1800

oplog_params {

replication_factor: 2

num_stripes: 1

need_sync: false

}

nfs_subnet_whitelist: "10.21.194.0/255.255.255.128,10.20.26.150/255.255.255.0"

data_contraction_policy {

dedup_compress_delay_secs: 0

on_disk_dedup_policy: kOff

}

fingerprint_on_write: true

advertised_capacity_bytes: 4398046511104

}

container_uuid: "a0bb8b93-ba8a-4ed3-8b54-f2eb201acd3a"

storage_pool_uuid: "d22c1983-5928-459c-8a55-3b94b07b46a2"

fsid: 3

epoch: 0

}

<略>

management_server_list {

management_server_name: "127.0.0.1"

management_server_type: kAcropolis

management_server_id: 33

management_server_uuid: "b658e0b3-6cdb-4ff3-9562-bdc755177dab"

}

management_server_list {

management_server_name: "10.21.193.27" # HyperVisor の IPアドレス

access_url: "qemu+ssh://10.21.193.27/system"

management_server_type: kKvm # KVM = AHV 構成

management_server_id: 58

parent_management_server_id: 33

management_server_uuid: "aa64ed4c-935e-41cf-852d-14141b8137d3"

parent_management_server_uuid: "b658e0b3-6cdb-4ff3-9562-bdc755177dab"

management_server_version: "el6.nutanix.20160925.84"

}

<略>

}

remote_site_list {

remote_name: "esx"

remote_cerebro_ip_list: "10.21.194.37"

remote_cerebro_port_list: 2020

enable_proxy: false

local_vstore_name: "test1234"

remote_vstore_name: "test0101"

cluster_id: 6346993287861168729

cluster_incarnation_id: 1489705096486047

compression_algorithm: kSnappy

compression_type: kLow

external_subnet: "10.21.194.0/255.255.255.0"

capabilities {

backup: false

disaster_recovery: true

supports_deduped_extents: true

supports_vsphere: true

supports_hyperv: false

supports_kvm: false

supports_vstore_stretching: true

supports_on_wire_sparse_extents: true

max_virtual_hardware_version {

vsphere_max_virtual_hardware_version: 11

}

supports_vstore_resolution: true

supports_diff_vblocks: true

cross_hypervisor_dr_capabilities_bitmap: 1152974281164980227

cerebro_features_bitmap: 108031

file_level_restore_capabilities_bitmap: 4194311

cluster_operation_mode: kNormal

cerebro_receive_rpc_timeout_msecs: -1

cluster_properties_bitmap: 0

minimum_supported_rpo_secs: 3600

}

remote_site_uuid: "00054ae0-ff18-9c9f-5815-0cc47ac0ea59"

network_mapping_uuid: "856996f3-4a86-4f58-b381-3967de451b2e"

stargate_version: 320

bandwidth_policy_uuid: "98779f3b-b592-4450-a653-5d192c004d84"

rackable_unit_model_names: "NX-1065-G4"

is_network_mapping_present_for_local_site: true

cluster_external_data_services_ip: "10.21.194.38"

file_server_capabilities {

bitmap: 6

}

}

cluster_incarnation_id: 1459999962759341

cluster_id: 3050639835602676466

cluster_name: "demo-ahv" # クラスタ名

aegis {

remote_support {

value: true

until_time_usecs: 1506700553989000

}

email_alerts {

value: true

until_time_usecs: 0

}

smtp_server { # SMTP サーバ名

address_list: "nutanix-com.mail.protection.outlook.com"

port: 25

}

smtp_server_type: kPlain

verbosity: kBasicPlusCoreDump

auto_support_config {

email_asups {

value: true

until_time_usecs: 0

}

send_email_asups_externally: true

aos_version: "danube-4.7.3.1-stable"

last_login_workflow_time_msecs: 1483703765628

remind_later: false

}

send_email_alerts_externally: true

send_alert_email_digest: true

}

vdisk_list_in_pithos: true

default_gateway_ip: "10.20.193.1" # Gateway

ntp_server_list: "pool.ntp.org"

name_server_ip_list: "10.21.253.10" # NTP

name_server_ip_list: "10.21.253.11"

rackable_unit_list {

rackable_unit_id: 34

rackable_unit_serial: "16AP65110008"

rackable_unit_model: kUseLayout

rackable_unit_model_name: "NX-1065-G4" # モデル名

rackable_unit_uuid: "84a2fac6-b6d6-4733-b9a5-a6786ab9ce4d"

}

snmp_info {

enabled: true

user_list {

username: "test"

auth_type: kSHA

auth_key: "64515144165C47134659"

priv_type: kAES

priv_key: "64515144165C47134659"

}

transport_list {

protocol: kUDP

port: 161

}

transport_list {

protocol: kTCP

port: 161

}

}

cassandra_schema_version: "el6-release-euphrates-5.1.2-stable-e429c7210f0786ed677edec3eef7e52f4d83881a"

auth_config {

auth_type_list: kLOCAL

auth_type_list: kDIRECTORY_SERVICE

directory_list {

directory_type: kACTIVE_DIRECTORY

connection_type: kLDAP

directory_url {

id_str: "demo-dc"

access_url: "ldap://10.21.193.20:389"

}

domain: "demo.nutanix.com"

group_search_type: kRECURSIVE

uuid: "8b63a85a-e13d-49cc-a435-a626f4b61548"

enabled_in_ssp: true

service_account {

username: "ssp-service-acct@demo.nutanix.com"

encrypted_password: "NDc4MzQ3MDIyMzI0NTI0OQ8UB6VL8mXjP7b457tcrKE="

}

}

directory_list {

directory_type: kACTIVE_DIRECTORY

connection_type: kLDAP

directory_url {

id_str: "TOC"

access_url: "ldap://10.0.73.1:389"

}

domain: "TOC.com.local"

uuid: "6495321e-2ca3-4bb5-a64c-b58698c094c6"

}

}

vstore_list {

vstore_id: 121883

vstore_name: "NTNX-AHV-PROD"

container_id: 121883

vstore_uuid: "a0bb8b93-ba8a-4ed3-8b54-f2eb201acd3a"

container_uuid: "a0bb8b93-ba8a-4ed3-8b54-f2eb201acd3a"

}

vstore_list {

vstore_id: 35405285

vstore_name: "NutanixManagementShare"

container_id: 35405285

vstore_uuid: "03c44825-1cd0-427b-a421-9397a5704b73"

container_uuid: "03c44825-1cd0-427b-a421-9397a5704b73"

}

release_version: "el6-release-euphrates-5.1.2-stable-e429c7210f0786ed677edec3eef7e52f4d83881a"

ssh_key_list {

key_id: "beb4123f-afc9-408e-a789-d0f4e56526b5"

pub_key: "ssh-rsa

<略>

cluster_content_cache_fingerprint_pct: 100

disk_tombstone_list: "BTHC5456069N480MGN"

disk_tombstone_list: "Z1X6KNED"

disk_tombstone_list: "Z1X6JM97"

cluster_external_ip: "10.21.193.37"

cluster_fault_tolerance_state {

current_max_fault_tolerance: 1

desired_max_fault_tolerance: 1

}

domain_fault_tolerance_state { # イベント

domains {

domain_type: kNode

components {

component_type: kZookeeperInstances

max_faults_tolerated: 1

last_update_secs: 1507215177

tolerance_details_message {

message_id: "Zookeeper can tolerate 1 node failure(s)"

}

}

components {

component_type: kCassandraRing

max_faults_tolerated: 1

last_update_secs: 1507215209

tolerance_details_message {

message_id: "All metadata ring partitions are fault tolerant"

}

}

components {

component_type: kStargateHealth

max_faults_tolerated: 1

last_update_secs: 1508438178

tolerance_details_message {

message_id: "Based on stargate health the cluster can tolerate a maximum of 1 node failure(s)"

}

}

<略>

}

shadow_clones_enabled: true

password_remote_login_enabled: true

stargate_version: 320

cluster_functions: 1

cluster_uuid: "00052fdc-bb27-00ad-2a56-0cc47ac0eaf2"

timezone: "America/Los_Angeles" # タイムゾーン

disable_on_disk_dedup: true

extended_nfs_fhandle_enabled: true

block_iscsi_target_ips {

logical_timestamp: 5

}

curator_scan_info {

partial_scan_execution_id: 42930

full_scan_execution_id: 42905

}

acropolis_ha_config {

failover_enabled: true

num_host_failures_to_tolerate: 0

logical_timestamp: 146

ha_state: kAcropolisHABestEffort

reservation_type: kAcropolisHANoReservations

reservation_type_override: false

removed_node_locality_cleared: true

}

ncc_version: "ncc-2.2.6" # NCC バージョン

cvm_security_compliance_config {

schedule: kDaily

aide: false

core: false

high_strength_password: false

banner: false

snmp_v3_only: false

}

hypervisor_security_compliance_config {

schedule: kDaily

aide: false

core: false

high_strength_password: false

banner: false

}

cluster_external_data_services_ip: "10.21.193.38"

disable_degraded_node_monitoring: true

cluster_operation_mode: kNormal

common_criteria_mode: false

iscsi_config {

external_clients_enabled: true

iscsi_client_uuid_fix_done: true

}

curator_stargate_protocol_config {

current_version: 1

desired_version: 1

enable_dedup_extents_two_phase_deletion: true

}

initialized_dedup_extents_two_phase_deletion: true

management_share_container_id: 35405285

default_ssp_container_id: 53603063

================

数が多いのですべての項目は説明しきれませんが、

上記のように zeus_config.txt を参照することで

クラスタ全体の構成情報を把握することができます。

ぜひ、Nutanixのスキルを伸ばしたい要望がありましたら、

ログファイルを採取し眺めてみることをお勧めします。

※ 今回は、zeus_config.txt だけだったので次回以降でも

ログバンドル内のファイルを説明します。

---

明日は、vExpert であり Nutanix NTC でもある

SH Hwang(@yueisu913)さん | Twitter

さんの登場です。AFS も楽しそうなので期待です!!